ノーマライズとは(意味)?

ノーマライズのデメリットについて

ノーマライズって音質は変わるの?

録音した音が小さいので調べていたら「ノーマライズ」という方法があるらしい。でも使ってみてもあまり効果が得られない。そもそもノーマライズとはなんだろう?正しい使い方とデメリットについて知りたい。という人はこの記事が参考になります。

ノーマライズを使ううえで大切なのは何でも大きくしてくれるわけではないということです。

そしてデメリットとされる「音質の変化」等についても正しい認識で理解することが望まれます。

ノーマライズ(オーディオノーマライズ)とは?

ノーマライズとは音量正規化という意味で効果としては次のようなものがあります。

音量正規化(ノーマライズ)とは、音響信号処理のひとつで、ある音声データ全体の音量(プログラムレベル)を分析し、特定の音量へ調整する処理である。 音声データを適正な音量に整えたり、複数の音声データの音量を統一する目的で用いられる

wikiより

もう少し詳しく説明するとノーマライズとは学術的に次のような定義があります。

2.3.2 ノーマライズ

ノーマライズは,ある音圧レベルをしきい値として,信号の最大音圧をしきい値に合わせ る処理を行う.時間領域で出力レベルを低下させるだけのため,聴感上での音質に変化がな いことが利点である.しかし,周波数ごとに歪みが発生する音圧が異なるため,音楽再生端 末によるイコライザーで周波数ごとに音圧を調整すると,歪みが発生する場合がある.ま た,歪みの発生していない周波数まで音圧を低下させることにもなる.

ネットで検索すると「オーディオノーマライズ」という言葉がありますが、やっていることは変わりません。「オーディオの音量を大きくする」という意味から、オーディオノーマライズという言葉が独り立ちしただけです。

ノーマライズすると音量が大きくなることからDTMでは「ノーマライズした方がいい!」と思っている人も多いですが、実はノーマライズしたことで大きくなる音量はもともとの素材の録音状況や音色に強く影響します。

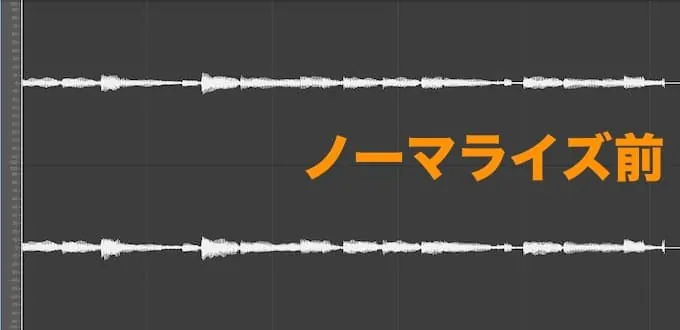

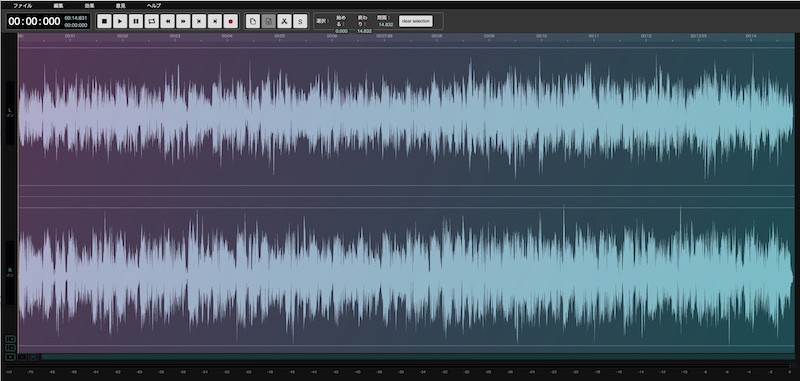

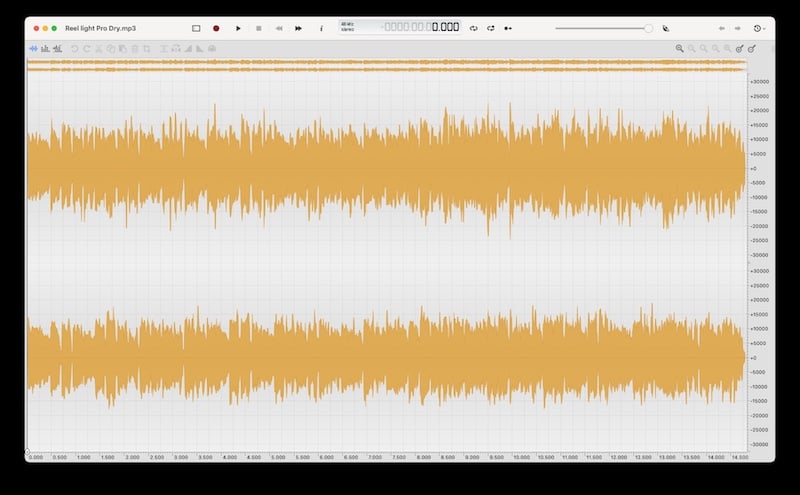

具体的にノーマライズするとどのような変化が起こるのかをLogicのノーマライズ機能を使い説明します。(ノーマライズ後での音量差にご注意ください)

ノーマライズをすることで全体の音量はあがりますが、注意したいのは一番大きい音(ピーク)がゼロデシベルを超えないように音量が自動調整されます。

上記の画像では十分な音量感の違いを確認できますが、アタックだけが強くすぐに減衰するスネアのような音色ではノーマライズしても小さい音はそれほど音量が上がりません。ドラムミックスなどでスネアが聞こえにくくなるの理由もアタックだけが強調されスネアらしさを感じるボディがあまり聞こえていないためです。

この問題を解決する方法として代表的なものがコンプレッサーになります。これは後述するノーマライズのメリット・デメリットで詳しく解説しています。

ノーマライズする意味について

ノーマライズすることで決められた制限(音割れしない)の中で音量を最大化することにあります。

つまり、ノーマライズしたいオーディオファイルのピークとそうでない部分の差が大きいととノーマライズしても実はそれほど音が大きくなった感じはしません。ピーク以外の箇所はノーマライズをしても音量を持ち上がりません。

ノーマライズの意味が均一化なのに対してアブをつけると「異常化」という意味になります。

凛として時雨のabnormalizeという曲があります。異常化を歌詞のテーマにもってきているところにセンスを感じます。

LoudnessNormalize(ラウドネスノーマライズ)とは

ラウドネスノーマライズとは上記で解説したノーマライズが音量ピークを基準にしているのに対して音圧を基準にしています。YoutubeやiTunesなどの基準はLUFSという単位で表され、およそ-14LUFSと言われています。そこにみたいない音源は自動的にそこまでノーマライズされ、逆に大きすぎるものは小さくなってしまうとされています。

ラウドネスノーマライズの必要性について

ラウドネスノーマライズが導入された経緯として多くの一般ユーザーが音楽をアップするようになった結果、安定した音圧が得られないために、導入された救済処置とする見方ができます。

小さい音量だったので大きくしていたら次の曲で爆音が流れたりしたらそのサービスは使いにくいと判断されてしまう可能性もあります。

ユーザービリティはネットコンテンツでもっとも基本としながければいけないサービスですから、極端な音量の変化や、プレイリストの音量がバラバラというの良いサービスとは言えません。

一部の人には音圧マシマシでアップしていたために「音質が変わってしまった!」とラウドネスノーマライズを避難する人もいますが、音楽をアップする目的はユーザーに対して気持ちの良い音楽を届けることですから、そのプラットフォームがラウドネスノーマライズを導入するのは自然な流れであると言えます。

ノーマライズのメリット・デメリット

メリット 音割れせずに音量上げてくれる音割れせずに音量上げてくれる

これは手動でやろうと思えばできないことではありません。しかし、3分の曲の中のどれが一番大きいピークなのかを調べてそこを基準にマスターのメーターで割れないようにするにはかなり手間がかかる作業です。それを自動化することで時短効率になります。

ではなぜノーマライズした方が良いのか?という話になりますね。

例えば、極端な例ですが、レコーディングしたギターが小さい場合、それをDAW上でダイナミクス処理(コンプ)等をする場合、音量が小さいとコンプの設定などかなり深く突っ込まないとコンプが作動しない場合があります。

そういう場合においてノーマライズは有効な音量調整機能として使うことはできます。

しかし、あくまで音量のピーク差をなくす機能ではないために、一箇所でも音量が大きい(例えば何かしらのノイズ)が入ってしまった場合はそれが原因で意図とする結果が得られないことがあるので注意が必要です。

デメリット 音圧をあげるための用途では使えない

大きい音量が0dBに到達してしまうとあとの小さい音量は上がりません。そのため、マスタリングで語られるような「音圧」を得ることは難しくなります。全体的な音圧をあげるのであればピークとそうでない場所の音量ができるだけ少ないのが望ましいことになります。

よくミックスで音圧を上げたいからノーマライズするという人もいますが、音圧をあげるためには最大値と最小値のボリューム差をなくさないといけません。それらを行うのがコンプレッサー等の仕事になります。

ノーマライズで音質は変わる?

ノーマライズすることで「音質が変わる」という話があります。ノーマライズ基本音量変化なのでそれ以上の処理をは行われていません。

それらを動画で確認してみます。(サイン波が発生するのでボリューム調整をお願いします)

方法は同じサイン波を並べて片方を逆位相にします。(LogicProXではGAINというプラグインを使っています)当然逆位相にすると打ち消し合います。次に片方をノーマライズします。

ノーマライズで増えた分をGAINのコントロールで下げ再び逆位相にすると打ち消し合って消えます。これで2つは同じデータであることがわかります。(これはミキサーのフェーダーでしても同じ結果がでます)

例えば音質変化をチェックする1つの方法として全く同じ音程で音量の異なるサイン波を2つ用意します。

1つは手動で0dB(DAWのステレオメーターがMAXの状態)1つはノーマライズで0dBにしたもの作り、その1つを逆相(音の波を反対にする)します。ノーマライズ後の波形が単なる音量調整であるならば、逆相にすると音は消えてしまいます。

そして当然、ノーマライズ後の音も逆相にすると音は消えるので「音質の変化」は起こっていない。と判断できます。

しかし、プロの世界ではもう少しシビアな見方をしている人もいるらしく、その条件であっても何かしらの変化が起こっている可能性がある。という話も聞きます。

では結論的に「ノーマライズすれば音質は変わるのか?」という問に対してDTMを楽しむものとして

「自分の耳で聞いて明らかに変わったと思ったら使わない方がいい」というのが私の結論です。その部分に必要以上のこだわりをもったところでおそらく曲がよくなるわけではありません。もっと良い曲を書くために考えることは山のようにあります。

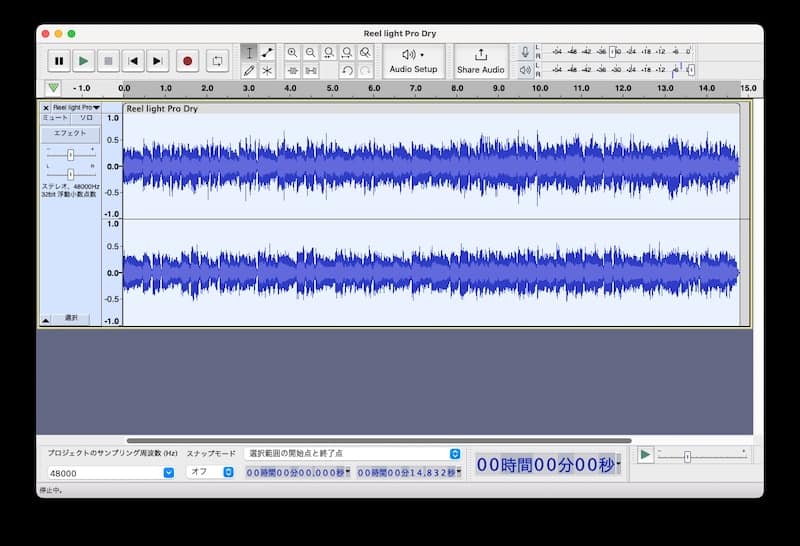

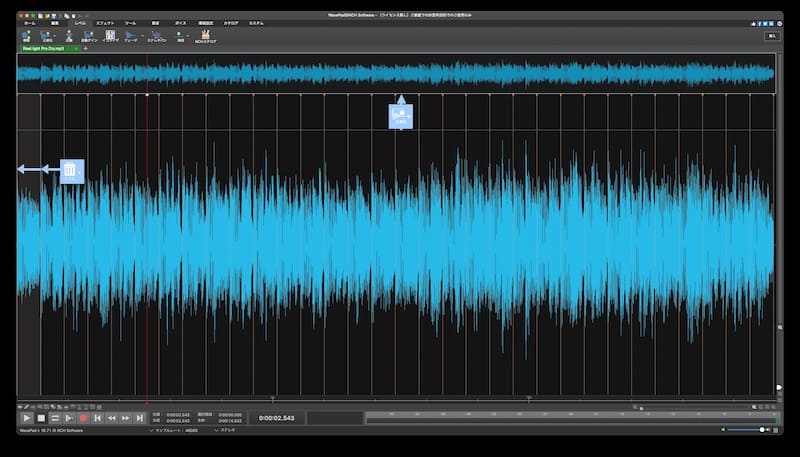

Macでノーマライズができる無料ソフト

audiomass

audiomassはオーディオ編集をブラウザ上で行います。基本的なエフェクトに加えてノーマライズも可能です。

Audacity

- 動作環境:macOS 10.13以降、2 GB以上のRAMと2 GHzのプロセッサ

- 対応フォーマット:WAV / AIFF / MP3 / OGG / FLAC / MP2

対応フォーマットの豊富さや操作性など無料オーディオ編集の定番ソフトです。

WavePad

- 動作環境:iOS 15.2以降またはiPadOS 15.2以降。

- 対応フォーマット:MP3、WAV、VOX、GSM、WMA、AU、AIF、FLAC、real audio、OGG、AAC、M4A、MID、AMR

無料版では機能が制限されますが、ノーマライズは可能です。

ocenaudio

- 動作環境:iOS 15.2以降(m1対応)

- 対応フォーマット:MP3、WAV、FLAC、WMA、MKV、WMV

日本ではあまり認知されていませんが、海外では有名なオープンソースタイプのオーディオ編集ソフトです。

ノーマライズの疑問あれこれ

Gainでも位相差は発生するのか?

各DAWにメーター以外の音量調整機能としてGAINというエフェクトプラグインがあります。これも音量の上下だけに使うものですが、音を逆相にしてチェックしても音は消えるのでノーマライズ同様同じデータであることがわかります。

そもそも生録にノーマライズによるデータの違いは検証できない今回はシンセ波形を使って100%再現可能な環境ですが、マイクを使った生録の場合に同じデータを揃えるのは不可能です。小さい音量で収録されてファイルをノーマライズすると当然フロアノイズも大きくなります。つまり音楽的に不必要なノイズも大きくなってしまいます。なので、ノーマライズを多用するべきではないのです。

cubase やLogic proのノーマライズは同じ?

DAWによって再生音質が異なるので、「DAWのノーマライズによって音質が変わる」という話があります。上記でお話した

逆相によるサイン波チェック方法でDAWごとにノーマライズをしてチェックしてみるとわかりますが消えるのでcubase やLogic proのノーマライズであっても結果は変わりません。

もし変わるのであれば他のプラグインを間違って使ってしまっている。書き出し時にディザーを入れてしまっている等の可能性があります。

ノーマライズで音が割れる?

ノーマライズして音がわれることは基本ありません。ノーマライズはDAW上で音が割れない最大値まで音量を自動であげることにあります。

それでも「ノーマライズして音が割れた」という言葉を耳にしたことがあるかもしれません。

この状況での音割れはそれまでのプラグイン処理等によるものがほとんどです。

例えば、ストリングス等にコンプをかけるとコンプが作動するときとそうでない場合があります。このときにコンプの設定が正しくできていないと音が割れたような状態になります。

それらをミックスしノーマライズすると「ノーマライズで音が割れた」と思ってしまいます。

0dBで音割れは発生しません。発生するのはそれまでの処理になると思ってトラックの音量差やプラグインをしっかりと見直すのがおすすめです。

しかし次の2つの条件下ではノーマライズで音が割れる可能性があります。

再生環境(スピーカー)

音の圧縮(mp3)

再生能力に乏しいスマホのスピーカー等では音が割れて聞こえるケースがあります。もともと全周波数をきれいにならす目的ではないのでどうしても再生できる音質に限界があります。

とくに中低域など音の密度が高い位置ではスピーカー自体が震えてしまたったためにヘッドフォンで音が割れていないと感じてもスピーカーでは割れている場合はこれれが原因です。

これはノーマライズに限ったことではありませんが、音をmp3化すると細かい情報(聞いていてもわからないレベルの情報)間引かれます。その結果、間引かれた音が原因で音割れが発生するケースがあります。この場合の対処は圧縮フォーマットを変更するか圧縮レートを上げて調整するしかありません。

mp3をノーマライズしたい

mp3をノーマライズする方法は

audacityやDAWなどの専用ソフトを使う

mp3機能だけに特化したソフト(プレイヤー機能を使う

DAWをお持ちであるならば、DAWにドラッグアンドドロップすることで読み込ませ、書き出し時にノーマライズを選択すればOKです。ただこの場合、mp3は一度wavデータとして取り扱うことになりますが、とくに問題となることはありません。

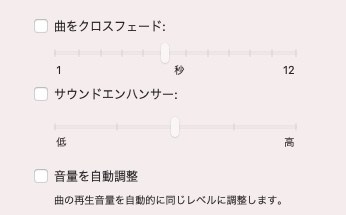

最近のミュージックプレイヤー(画像ではitunes)自動音量調整機能(ノーマライズ)があるのでそこをチェックすることでノーマライズしてくれます。

ノーマライズに頼らない最適な録音レベルについて

小さい音をノーマライズすれば自動で割れないレベルにしてくれるのはわかったけれど、ノーマライズする必要がないくらい音量で録音するためにはどうしたらよいのか?という疑問を持つようになるかもしれません。

この場合考え方として一番大きい音がメーターのMAX(0dB)につかないようにすれば大丈夫なわけですが、正直それを手動でコントロールするのは難しい話です。

なので目安として一番大きい音がメーターでいうところの-6dBを天井として見ると問題ありません。なぜ-6dBくらいかというと、その後のエフェクトプラグインでそれだけマージン(音を作る隙間)をあけておくという考えです。

例えば、8kHzあたりを3dBくらいプッシュしたい場合、もうそれだけでのこり3dBちょっとしか余裕がなくなるわけです。

おまけ 24bitと32bitfで書き出した場合の違い

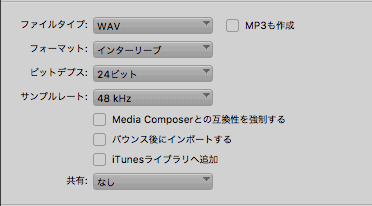

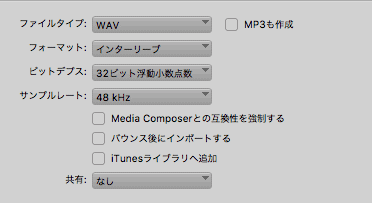

この状況で24bit書き出しをすると

もはやサイン波ではありませんが、これを32bitFで書き出すと

割れないwサイン波のまま上記の使い方は一般的ではないですが、書き出しでこれだけ違いがあるということです。32bitFloatに関してはsleep Freaksさんのこの動画による説明がわかりやすいのでオススメです。

Twitter界隈でのノーマライズに対する意見

他のリプにもありますが、音の解像度が低くなってしまう事と、ノーマライズの問題点として位相エラーが出ることがあるようです。

厳密に言えば の話であります故、-18dB等の強烈な小さい音でない限りは殆ど気にならないのではないかとも思いますけれど

— まめ丸にる吉(( ‘ᾥ’ )) (@mamemaruniruki1) September 25, 2018

詳しくなく自信もなく憶測なのですが、

ノーマライズはコピーの拡大のように画素(この場合デジタル化された周波のデコボコ)の粗さはそのまま大きくなります。

もともと大きなものだと粗さはないですが、入っているデータのデコボコをただそのまま大きくします。(gateとかあれば別だと思います— マサヤン/今年はでじっくフェスタはなし/黒金待機 (@masayan_d00m) September 25, 2018

これらを見る限り画素数の問題が1番わかりやすいかもしれませんね」デジカメの画像も拡大していくとボコボコしてくる。あれと同じようなものみたいです。

まともに録音したことないDTMerだけどダメな原因は、録音した音をそのまま大きくしたら一緒に録音された普通は聞こえない程度のノイズも同じように大きくなるから、と理解してた(「・ω・)「

それだけじゃないのね。 https://t.co/y6UcnKpQ9D— やまちゃは (@Yamachanz2) September 25, 2018

まとめ

一般的なチェックをする限り、ノーマライズもゲインも「フェーダー調整でしかない」と言えそうです。これがアナログ的なプロセスを含むプラグインなどである場合は当然同じデータにはならないと思います。

しかしノーマライズやゲインで「音が変わる変わらない」を議論する前に「一曲でも良い曲を書け」というのが一番の検証結果な気がしています。

コメント

コメント一覧 (4件)

初めまして。こちらのブログを読むのは初めてですが、この検証を拝読していろいろと違和感を覚えましたので、不躾な投稿させていただく失礼をお許しください。

違和感その1

この検証は、フェーダーでは全く劣化しないという前提が必要ですが、その根拠はありますか?

そもそも、ノーマライズによる劣化よりもフェーダーによる劣化の方が大きい可能性も排除しきれません。もちろん、劣化の度合いが同等である可能性やフェーダーによる劣化の方が小さい可能性もありますし、パラメーターによってその度合いが変化する可能性もありますが、いずれにしても、デジタル演算をしている以上、どのプロセスにおいても全く無劣化ということはあり得ない話です。

ついでに言うと、演算による劣化が起こりにくい部分ではありますが、位相反転の操作によって劣化した可能性も完全に排除することはできません。

違和感その2

> そうでない普通のファイルのボリュームを合わせます。

どのように合わせたのでしょうか?

インジケーターを目視して目分量で合わせたというのは論外ですが、具体的にとのような方法で合わせたのか、記載する必要があります。

「結果はこんな感じです」の音を聴く限り、かなりはっきりと正弦波が残っていますから、音量が完全に一致していない可能性も排除できません。音量が一致していても位相が変わっていれば正弦波は残りますが、この検証結果だけでは音量の不一致なのか、位相の不一致なのかがはっきりしません。

それでも、検証結果の音には揺れが発生しているのが分かりますから、劣化している事実は分かります。しかしながら、それがノーマライズによるものである証明としては不完全です。

違和感その3

以上2点だけでも検証として不完全ですが、ベンダーによる差異を考慮していない部分も違和感を覚えました。

ノーマライズの目的はひとつですが、真面目に演算していたら恐ろしく時間がかかるものを、いかに速く演算するかで各ベンダーが知恵を絞る部分でもありますから、当然ながら結果にも差が出るはずです。

ベンダーによって「これはやめておいた方がいい」というものもあれば、「これならさほど問題にはならない」というものもありそうです。録音ソースによって向き不向きということがあるかも知れません。

ノーマライズの一般論として述べるのであれば、複数の商品、複数の音源を比較しなければ客観性がありません。

ちなみに、エフェクトの質を比較するには、ソースとしてホワイトノイズを使用し、スペクトラムアナライザーで観察するのも有効です。

雑感

アナログミキサーだとDAWとは比較にならないほど劣化が起こります。増幅器やイコライザーを通る度に発生する歪は言うに及ばず、フェーダーを動かすと位相も動くのは当たり前、さらにノイズもたっぷり乗っかります。

それでも、ミキサーを通さずに音声信号をミックスすることはできませんから、先人は機器の癖を感じ取った上でベストなミキシングをして音を仕上げてきました。

DAWではノーマライスをしなくても信号が劣化する要因は無数にあります。それでも、アナログに比べれば劣化の度合いが激的に少ない環境であり、我々が神経を遣うべきことは別のところにたくさんあるのではないでしょうか。いくら劣化が少なくても、作った音楽がヘボかったら何の意味もありません。

もちろん、劣化はするよりはしない方がいいに決まっています。

それは、エフェクトはできるだけ最後に近い方でかけるとか、無加工のオリジナルファイルを保存しておいて、いつでもやり直しができる状態にしておくというような原則さえ守っていればよい話であって、完全無劣化を求めるのであれば、ゲインやフェーダーをいじることもできないし、極論を言えばアンプやスピーカーを通すこともできません。二進数のダンプデータを眺めて「あぁ、無劣化は最高」と悦に浸った日にゃ、完全に変態です。

結局、劣化は必ず起こるものという前提のもと、音楽制作のプロセスにおいて何を優先させるかという話ではないでしょうか。ノーマライズすることで作業の効率や質が上がったとすれば、そっちのメリットの方が大きいということもあるでしょう。

極端にレベルの小さい音源ファイルも、最終的には何らかの方法で必要な音量に上げる必要があるのですから、ノーマライズをしなくても演算による劣化は必ず発生します。その劣化の質と、それがどこで発生するかの違いだけです。

この記事の最大の違和感は、いかにもノーマライズだけが悪であるかのように断言していることでしょう。

せめて「ノーマライズによる劣化を調べてみた」程度であれば「検証方法が甘いな」だけで済んだのですが、ノーマライズだけがダメで他のプロセスは無問題であるかのようなストーリーが、何とも受け入れ難く感じられました。

考察、表現、の甘さすべてにおいてケンタウルスさんのご指摘どおりです。

これを検証という言葉で表現するには稚拙だったかもしれません。

ノーマライズだけを問題視している点においてはそのような意図はなかったのですが、

読み手の立場ではそうとれる内容であると感じます。

専門家であろうケンタウルスさんにはお見苦しい記事が多い中での

冷静かつ鋭い指摘ありがたく受け止めたいと思います。

記事を読んでいただいている時点でお気づきとは思いますが、

ケンタウルスさんの違和感に答えられるほどの知識は持ち合わせていません。

私の記事は趣味範囲の世界の知識を自分なりに解釈したものです。

ですからまだまだ知らないことのほうが多く、

専門家の人からみればお話にならない部分も多々あるのは重々承知です。

それをわかったうえで「今回の記事を読んでくれた人が

「どうなんだろう?」「ちょっと試してみるか」といったきっかけになれれば

嬉しいと思う程度でした。

今回の指摘を受けてよりよいブログにしていけるよう精進しますので、

また気になる記事がありましたら、読んでいただけるとありがたく思います。

感じたことは前の方が述べた通りです。

僕の環境でも検証して動画に録ってみましたが条件は違いますが綺麗に打ち消しあいました。

https://www.youtube.com/watch?v=wI0kk8X0wis&t=31s

もしやどこかで別の処理が音源にされていませんか?

音源のゲインが非常に高いのでどこかでDAW内部のリミッターがかかっていたりしないでしょうか。

厳しい指摘をさせていただいたにもかかわらず、ご丁寧な返答をいただき、ありがとうございました。

学術論文でさえ初歩的なミスが見つかることがありますし、慎重に書かれたものでも別の人に覆される可能性は常にあり、そうして議論が起こること自体に意義があるという考え方が一般的かと思います。

かつて義務教育で「正しいこと」として教えられていたことが、のちに訂正されて常識自体が変わることがあるというのも、大人の多くが体験していることでしょう。

そういう意味で、翌日の記事に書かれている「間違いOK」という趣旨は、基本的に理解できるものです。

とは言え、この種の話は検証方法さえ正しければ客観的な結論を得られるものですから、それほど遠大なテーマという訳でもありません。

この度の記事が多くの反響を呼んだことは、むしろ読み手の姿勢が問われた一件だと考えます。

UGさんの記事は、問題提起から始まり、検証の過程をつまびらかに開示した上で結論を導き出しています。この手順は論述として模範的であり、非常に説得力があります。

ただし、その結論に至る過程が不適切だったとしても、それに気づかない人を納得させてしまう力もあります。私はこの記事の検証過程に疑念を抱き、恣意的な「結論ありきのストーリー」ではないかとさえ思ってしまいましたが、Twitterでは鵜呑みにした人が肯定的にRTしている場面も多く見られました。今回に限らず、怪しい情報がまことしやかに出回ることは珍しくありません。

ノーマライズによって音が劣化しようが音に磨きがかかろうが全く人畜無害、損する人も得する人もいませんから、発信者であるUGさんに社会的な責任は全くありませんが、読み手側の素養と姿勢が試された場面ではあったと思います。

そういう私も、中学生時代にはトンデモ本に翻弄されて3年後に反証本に出会うまで呪縛が解けなかったことがあったり、近年も巧妙に作られたパロディーを一瞬真実だと誤解してしまった経験があります。それだけに、流れて来た情報には一層慎重になってしまうところがあるのも正直なところです。

この記事は、内容の妥当性はともかく、検証の過程がきちんと書かれていたために、私は疑念を具体的に指摘することもできましたし、リプライを受け入れる姿勢をお持ちであったことについては大変評価しております。

もしかしたら、また気になる情報がこのブログから流れて来たら不躾な投稿をさせていただくことがあるかも知れませんが、ご自身のブログですので、思う存分自己表現していただければと思います。